Data Science Beratung

Vorsprung durch Wissen: Mit Data Science gezieltere Geschäftsentscheidungen treffen!

Was ist Data Science?

Data Science (deutsch: Datenwissenschaft) bezeichnet im Allgemeinen die Extraktion von Wissen und das Auffinden von Mustern aus strukturierten und unstrukturierten Daten, um Fragen anhand von Daten zu beantworten, welche bei der Entscheidungsfindung helfen sollen.

Was ist das Ziel von Data Science?

Ob E-Mails, Surfverhalten oder Transaktiondaten – die Zahl und Vielfalt der Daten, die ein Unternehmen über seine Kunden sammeln kann, wächst täglich. Viele Unternehmen sind sich dieser Tatsache bewusst und haben in den vergangenen Jahren Infrastrukturen aufgebaut, um Kundendaten zu speichern. Doch dieser gespeicherte Datenschatz muss geborgen werden, um sich aus diesen Daten handlungsweisende Informationen zu ziehen. Das Ziel von Data Science ist demnach das Aufdecken von Trends, Mustern und Verbindungen in großen Datensätzen durch vielfältige Methoden wie Programmierung, Statistik, Machine Learning oder Künstliche Intelligenz (KI).

CINTELLIC untertsützt Sie individuell – je nach Use Case – gerne bei der Auswahl und Anwendung von geeigneten Data-Science-Methoden, um aus Ihren Kundendaten wertvolle Customer Insights zu gewinnen.

Inhaltsverzeichnis:

- Data-Science-Projekte: Herausforderungen & Problemstellungen

- Typische Kundenfragen zum Thema Data Science

- CINTELLIC liefert Antworten: Unser Ansatz der Data Sciene Beratung

- Unsere Data Science Leistungspakete

- Ihre Mehrwerte der CINTELLIC Data Science Beratung

- Erfolgsgeschichten: Unsere Referenzen im Bereich Data Science

- Data Science: Publikationen & Whitepaper zum Thema

- Kontakt

Data-Science-Projekte: Herausforderungen & Problemstellungen

Die Vielfalt von Data Science-Projekten ist unerschöpflich und kann über erste Datenanalysen zu Modellentwicklungen auch ganze Prozessautomatisierungen beinhalten. Im Gegensatz zu Softwareprojekten oder auch Tool-Implementierungen sind Data Science-Projekte zwar oftmals weniger komplex und langwierig, doch auch hier gibt es Herausforderungen, die bewältigt werden müssen, wie die folgende Auswahl darstellt:

- Data Science-Projekte haben überwiegend einen interdisziplinären Charakter und erfordern somit eine Koordination von unterschiedlichen Fähigkeiten

- Data Science ist ein riesiger Wissensbereich, so dass es je nach Use Case zu fehlender Expertise kommen kann oder spezialisierte Profile nicht verfügbar sind

- Durch immer größer werdende Datenmengen, gilt es einen verstärkten Fokus auf die Verwendung der richtigen Daten zu legen

- In vielen Unternehmen ist die technologische Architektur nicht auf Data Science ausgerichtet. Dies kann Projektziele schnell verzögern.

- Es bedarf eines abgestimmten Aufbaus und eine erfolgreiche Etablierung von Workflows, die von allen Beteiligten getragen werden.

- Auch bei Data-Science-Projekten kommt es auf die Projektplanung an, um die Unternehmensziele zu erreichen und schnell auf Herausforderungen reagieren zu können

Typische Kundenfragen zum Thema Data Science

- Welche Modelle/Modellkombinationen sind für unser Unternehmen die optimale Lösung? Wie unterstützen diese die Unternehmensstrategie langfristig?

- Welche unentdeckten Potenziale liegen in unseren Unternehmensdaten vor und wie können wir diese nutzen?

- Wie können wir unsere gesammelten Unternehmensdaten strukturieren? Was sind sinnvolle Pre-Processing-Schritte, um die Daten für weitere Analysen zu nutzen?

- Wie können Modelle bei der Prozessautomatisierung unterstützen, um die Effizienz zu steigern? Wie stelle ich sicher, dass die Modelle automatisiert laufen?

- Sind die Ergebnisse der Modelle valide und kann ich damit zukunftssicher planen?

- Welche Modelle optimieren z. B. unsere Marketingstrategien und verbessern die Effektivität unserer Kampagnen?

- Steuern wir unsere Marketingaktivitäten überhaupt richtig aus?

- Wir tracken bereits das Verhalten unserer Kund:innen auf unserer Website. Wie können wir daraus Mehrwerte sowohl für das Unternehmen als auch für die Kund:innen generieren? Können wir unsere Website/Onlineshop weiter personalisieren?

- Wie können wir die Conversion Rate, den Absatz oder den Wert der Werbung auf unseren Plattformen quantifizieren und maximieren?

Das könnte Sie auch interessieren: Unsere Customer Analytics Beratung

-

Werfen Sie doch mal einen Blick in unsere Customer Analytics Beratung! Hier wenden wir unter anderem die verschiedenen Data-Science-Methoden an.

CINTELLIC liefert Antworten: Unser Ansatz der Data Sciene Beratung

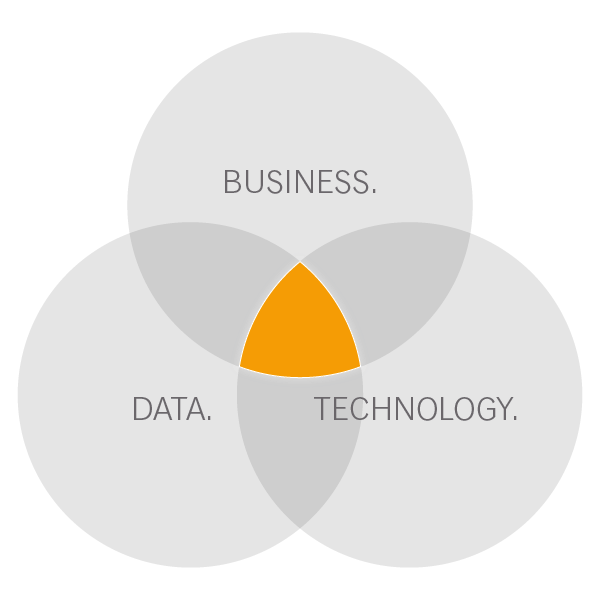

Wir von CINTELLIC verstehen uns als Business-Beratung und stellen in jedem Projekt Ihren individuellen Business-Mehrwert in den Fokus. Unsere Berater:innen verfügen daher nicht nur über Datenexpertise und ein umfassendes Technologieverständnis, sondern auch über das nötige Business Know-how. Denn nur was Ihnen einen Mehrwert bringt, wollen wir umsetzen. Nach diesem Prinzip haben wir in den vergangenen Jahren zahlreiche Kunden erfolgreich beraten und gemeinsam mit ihnen Data-Science-Projekte umgesetzt.

Bei folgenden Punkten unterstützen wir Sie gerne:

- Entwicklung und Umsetzung Ihrer Data Science Strategie

- Identifikation von Use Cases, welche Sie mit Ihren Daten umsetzen können

- Eine richtige Aufbereitung Ihrer Daten

- Umsetzung Ihrer Use Cases in Modellen

- Beurteilung von Modellen und dem Vorgehen (Proof of Concept)

- Optimierung und Entwicklung Ihrer Algorithmen und Analyseverfahren

- Auswahl und Implementierung der richtigen Technologie für Ihre Use Cases

- Kompetenzaufbau in Ihrem Data-Science-Team

Gerne zeigen wir Ihnen Best Practices, entwickeln gemeinsam mit Ihnen eine Strategie für Ihre Data-Science-Projekte und setzen diese gemeinsam um. Profitieren Sie von unserer Branchenerfahrung und der langjährigen Zusammenarbeit mit unseren Technologiepartnern.

Data Science Beratung: Der CINTELLIC-Ansatz

Wir begleiten Sie während des gesamten Projektes ausführlich und verständlich. Unser Vorgehen bei der Umsetzung von AI & Data Analytics Projekten gliedert sich dabei in mehrere Phasen, die iterativ durchlaufen werden:

Phase 1: Datenerfassung

Bei der Datenerfassung handelt es sich um einen Prozess, der Daten von den Quellspeicherorten an die Zielspeicherorte verschiebt. Dieser Prozess wird benötigt, um die darauffolgenden Analyse-Prozesse auszuführen, ohne die IT-Systemlandschaft zu verlangsamen. Ein Quellspeicherort könnte Ihr Data Warehouse (DWH) oder Data Lake sein. Auch externe Datenquellen, wie Wetterdaten, Regionaldatenbanken oder auch Daten von statistischen Bundesämtern wie dem Institut für Arbeit und Beschäftigung (IAB) lassen sich in diesen Prozess inkludieren.

Phase 2: Datenaufbereitung

Bevor Sie Modelle trainieren und Vorhersagen mit diesen treffen können, müssen die Daten bereinigt werden. In der Praxis sind Daten häufig überladen, weisen fehlende Werte oder fehlerhafte Daten auf. Wir überprüfen die Qualität Ihrer Daten und tätigen die ersten Transformations- und Aggregationsschritte, um aus diesen aussagekräftige Formate zu generieren. Dabei prüfen wir die Daten auch auf Outlier (Ausreißer) und inkohärente Daten. Die nun bereinigten und aussagekräftigen Daten bilden die Grundlage für weitere Schritte.

Phase 3: Pre-Processing

Im folgenden Pre-Processing wenden wir verschiedene Analysemethoden an, um die Daten, die immer noch in einer Rohform vorliegen, in ein Format umzuwandeln, das beim Data Mining oder Maschinellem Lernen effektiver verarbeitet werden kann. Dies gewährleistet die genauesten Ergebnisse.

Zuerst kann eine Datenreduzierung, z. B. mittels der Principal Component Analysis, sinnvoll sein, um die Rohdaten in eine einfachere Form zu bringen. Die weiteren Aufbereitungsschritte werden so gewählt, dass wir Ihr Projektziel am effektivsten erreichen. Dies könnte eine Strukturierung von unstrukturierten Daten, die Kombination auffälliger Variablen oder die Identifizierung wichtiger Datenbereiche, auf die der Fokus gesetzt werden sollte, beinhalten.

Auf Grundlage dieser Vorarbeit wenden wir das Feature Engineering auf die Daten an, um einen Datensatz zu generieren der so organisiert ist, dass ein optimales Gleichgewicht zwischen der Trainingszeit für ein neues Modell und der erforderlichen Rechenleistung erreicht wird.

Zum Schluss teilen wir Ihre Daten in zwei Datensätze. Der erste Satz wird zum Trainieren eines Modells für maschinelles Lernen oder Deep Learning verwendet. Der zweite Satz wird als Testdatensatz genutzt, um die Genauigkeit und Robustheit des resultierenden Modells zu beurteilen.

Phase 4: Modellentwicklung / Operationalisierungsproblematiken

Ein gängiges Problem bei der Modellentwicklung ist die Operationalisierungsproblematik. Diese besagt, dass nicht alle Daten auf ein Modell passen und andersherum auch nicht alle Modelle auf die vorhandenen Daten. Somit existiert für einen speziellen Datensatz kein perfektes Modell.

Unser Ziel ist es daher, ein Modell zu identifizieren, welches für Ihre Daten die größte Aussagekraft und Güte besitzt. Dieses Modell kann auch aus mehreren Modellen bestehen, die zusammengeführt eine noch genauere Vorhersagegüte ermöglichen. Deshalb evaluieren wir für Sie die geeignetsten Modelle und garantieren Ihnen somit die bestmögliche Genauigkeit.

Phase 5: Modelltraining

Beim Training eines Machine Learning-Modells werden dem Algorithmus Trainingsdaten zum Lernen bereitgestellt. Damit der Algorithmus jedoch lernen kann, müssen die Trainingsdaten auch die richtigen Antworten beinhalten. Dadurch wird ihm ermöglicht, während des Lernens in den Trainingsdaten Muster zu finden. Es sind also die Eingabedaten (die Antwort, die Sie vorhersagen möchten) in den Trainingsdaten enthalten, sodass ein Modell ausgegeben wird, das dieses Muster erfasst. Der Begriff „Modell“ bezieht sich also auf das Modell-Artefakt, das durch den Trainingsprozess erstellt wird. Dieser Prozess ist die Trainpipeline.

Auf dieses Training folgt das Testen bzw. das Überprüfen des Modells auf seine korrekte Funktionsweise. Dafür wird der zweite Teil der Daten, nämlich die Testdaten – die der Algorithmus während des Lernens nicht gesehen hat – verwendet und dem Modell vorgelegt. Die Testdaten beinhalten zwar die korrekten Eingabedaten (Antwort, die vorhergesagt werden soll), jedoch sieht das Modell diese nicht. Dadurch können die auf den Testdaten getätigten Vorhersagen des Modells mit den korrekten Eingabedaten aus den Testdaten verglichen und beurteilt werden. Dies gewährleistet eine korrekte Funktionsweise des Modelles. Dieser Prozess ist die Testpipeline.

Phase 6: Forecasts

Eine gute Methode zur Verbesserung der Vorhersagegenauigkeit besteht darin, verschiedene Methoden auf das gleiche Problem anzuwenden und die daraus resultierenden Vorhersagen zu ermitteln. Sehr häufig stellt eine Kombination aus mehreren Modellen eine deutlich bessere Performance-Steigerung gegenüber einem einzigem Modell dar. Dadurch können wir durch Kombination verschiedener Forecasts das optimale Ergebnis für Ihren Anwendungsfall erreichen.

Phase 7: Forecastvalidierung

Eine Vorhersage lässt sich leicht treffen, jedoch lässt sich nicht immer mit einfachem Hinsehen feststellen wie gut diese Vorhersage ist. Um die Qualität eines Forecasts zu bewerten, verwenden wir verschiedene Techniken. Je nach Anwendungsfall können die Methoden von einfachen traditionellen Statistiken und Bewertungen, bis hin zu Methoden für eine detailliertere Diagnose und wissenschaftliche Überprüfungen reichen. Das Aufbauen dieser Validierung der Vorhersagequalität wird nicht nur zum reinen Bewerten der Güte benötigt, sondern auch um verschiedene Modelle miteinander vergleichen zu können. Darüber hinaus aber auch für die Überwachung der Prognosequalität. Wie genau sind die Prognosen und wie verbessern sie sich im Laufe der Zeit? Diese Validierung wird also nicht nur für die Entscheidungsfindung der Modelle sondern auch für spätere Prozesse wie dem Pipelining benötigt.

Phase 8: Aufbau einer Pipeline

Die Continous Integration und Continous Deployment (CI/CD) sind ein unverzichtbarer Schritt in der modernen Softwareentwicklung. Sie stehen für das systematische Automatisieren der Lebenszyklen der Softwareentwicklung. Die Entwicklung eines Modells für maschinelles Lernen ist hier nicht anders – es handelt sich um einen technischen Prozess mit einem Lebenszyklus, der Entwurf, Implementierung, Testing und Bereitstellung umfasst. Die Pipeline für Machine Learning kapselt und automatisiert genau diesen Prozess. Dabei arbeitet die Pipeline iterativ, da jeder Schritt kontinuierlich wiederholt wird, um die Genauigkeit des Modells zu gewährleisten. Das Modell wird also nicht einmalig erstellt und ausgeliefert, sondern kontinuierlich innerhalb der Pipeline validiert und bei Bedarf neu trainiert, um das Modell korrekt auszurichten.

Das Aufbauen solch einer Pipeline ermöglicht die Ausführung des Modells in einer produktiven IT-Systemlandschaft. Somit bildet die Pipeline für maschinelles Lernen das zentrale Produkt. Sie beinhaltet nicht nur das Modell sondern auch einen Apparat zum kontinuierlichen Testen, Evaluieren und Ausliefern der Modelle. Unabhängig davon, ob Sie mehrere Modelle oder ein einzelnes Modell aufgebaut haben, wird Ihr Modell früher oder später aktualisiert werden müssen, um eine konstante und zuverlässige Vorhersagegüte zu erreichen. Demnach ist eine vollständige End-to-End-Pipeline für maschinelles Lernen ein Muss.

Phase 9: Integration IT-Systemlandschaft

Nachdem das Modell fertig erstellt wurde, wird es von uns in Ihre IT-Systemlandschaft integriert. Dabei ist unser Ziel nicht nur das fertige Modell in Ihre produktiven Systeme einzubauen, sondern auch die hieraus gewonnenen Daten und Ergebnisse wieder in Ihr DWH oder Data Mart zurückzuführen. So besitzen Sie nicht nur die gewonnenen Ergebnisse des integrierten Modells, sondern Sie sind auch in der Lage diese neu gewonnenen Daten für darauf aufbauende Dienste, Prozesse und Modelle zu verwenden.

Phase 10: Aufbau eines Reportings

Damit Sie nicht auf unverständliche Zahlen schauen müssen, bauen wir Ihnen eine visuelle Repräsentation der Key Performance Indikatoren auf. Dieses Dashboard ermöglicht es allen Stakeholdern, unabhängig von Ihrem technischen Hintergrund, die Vorhersagen in Echtzeit zu analysieren. Solch ein interaktives Dashboard bietet den Nutzern eine aussagekräftige Datenvisualisierung, die Erkundung und Interaktivität fördert. Dies mündet in einem gesteigerten Verständnis darüber, warum Prozesse derzeit so sind, wie sie sind, oder warum bestimmte Ergebnisse eingetreten sind.

Unsere Data Science Leistungspakete

-

Explorative Datenanalyse

Kennen Sie Ihre Potentiale in Ihren (Roh-)Daten?

Die Explorative Datenanalyse kann Ihnen vielfältige Potentiale und Informationen zu Ihrer Datenqualitäten aufzeigen. Dadurch gewinnen Sie ein verbessertes Verständnis zu den Variablen und deren Beziehung zueinander, erkennen versteckte Kausalitäten und generieren neues Wissen. Wissen, welches Sie für Ihre Strategieplanungen, Entscheidungsprozesse und Innovationen nutzen können.

-

Prognosemodelle

Erkennen von Chancen und Risiken! Über Prognosemodelle lassen sich geeignete Kampagnen und Ziele ableiten, um zukünftige Potenziale zu erkennen und zu nutzen und drohende Probleme frühzeitig abzuwenden. Dafür entwickeln wir mit Ihnen moderne und valide Prognosemodelle. Um alle Einflussfaktoren zu berücksichtigen, basieren diese KI-Algorithmen in der Regel auf historische oder Realtime-Daten, angereichert mit externen Mikro- und Makrodaten.

-

Scoringmodell

Wagen Sie den Blick in die Zukunft? Scoringmodelle können die Vorhersagegenauigkeit wesentlich verbessern auch wenn sich die Schwierigkeiten von Vorhersagen nicht komplett beseitigen lassen.

Die Erstellung von Scores auf Basis Ihrer Kunden- und Unternehmensdaten verbessern dabei nicht nur Ihr CRM sondern stellen es auch gleich auf eine analytische Grundlage. Sehen Sie hier.

-

Natural Language Processing

Kommunikation zwischen Mensch und Maschine! Die Kombination von maschinellem Lernen und der Anwendung von Sprachwissenschaften ermöglicht es und bietet Ihnen zahlreiche Möglichkeiten in der Anwendung.

Dabei wird Natural Language Processing (NLP) als ein Algorithmus zur maschinellen Verarbeitung von menschlicher Sprache und Texten angewendet.

-

Text Mining

E-Mails, Briefe, Kommentare – Texte liegen in vielfältigen Variationen vor. Diese alle einzeln zu lesen und auszuwerten ist fast unmöglich. Mithilfe von Algorithmen lassen sich Muster von Kunden in Texten unterschiedlichster Formate leicht erkennen und aufdecken. Gemeinsam mit Ihnen gehen wir der Bedeutung Ihrer Textdokumente auf den Grund. Mehr zu Text Mining finden Sie hier.

Ihre Mehrwerte der CINTELLIC Data Science Beratung

Wir unterstützen Sie bei allen Themen rund um Ihre Daten – ob bei fachlichen oder methodischen Fragestellungen, Datenaufbereitungen, Analysemöglichkeiten oder direkt bei der Umsetzung und Einführung von Modellen und Prozessautomatisierungen.

Sie profitieren dabei nicht nur von unserem externen Blick, sondern auch von unserer langjährigen Erfahrung. Dabei ist es uns ein großes Anliegen systematisch und objektiv vorzugehen und alle relevanten Stakeholder von Beginn an in ein Boot zu holen, um über ein gemeinsames Commitment die Unternehmensziele erfolgreich zu erreichen.

Wir bauen bei unserem Vorgehen auf einen ganzheitlichen Ansatz und schlagen Ihnen genau das Konzept vor, welches Sie brauchen. Auch bei der Umsetzung einzelner unserer Leistungspakete verlieren wir das große Bild nicht aus den Augen und schauen immer über den Tellerrand, um tangierende Projekte/Abteilungen positiv zu unterstützen.

Fragen Sie hier gerne nach unseren spezialisierten Data Science-Profilen.

Erfolgsgeschichten: Unsere Referenzen im Bereich Data Science

Unser Berater:innen-Team verfügt über langjährige Erfahrungen in der Umsetzung von Data Science Projekten. Besonders in den Branchen Telekommunikation, Banken und Handel durften wir in den vergangenen Jahren zahlreiche Projekte begleiten und erfolgreich umsetzen. Sprechen Sie uns gerne im unverbindlichen Erstberatungstermin auf unsere Referenzprojekte zum Thema Data Science an.